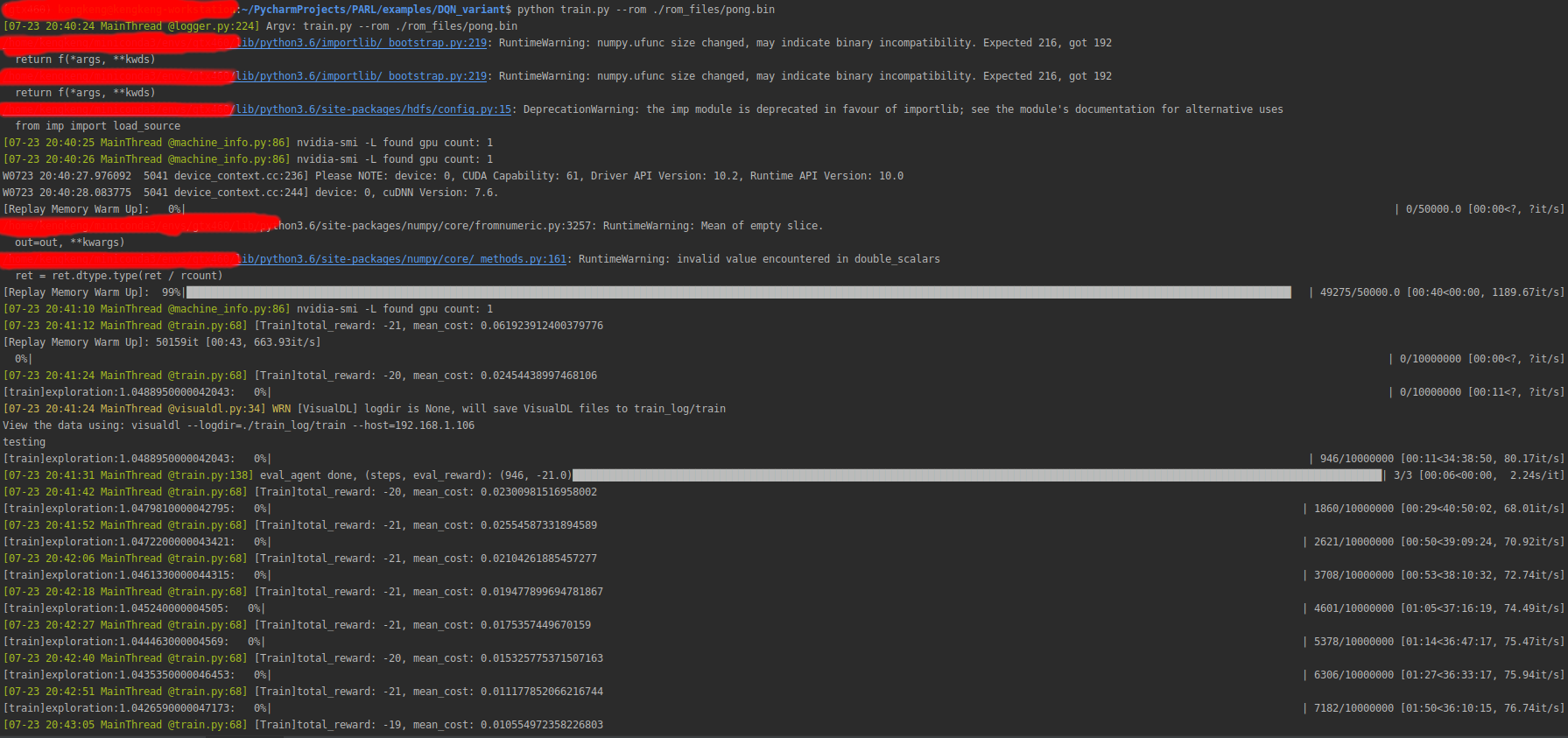

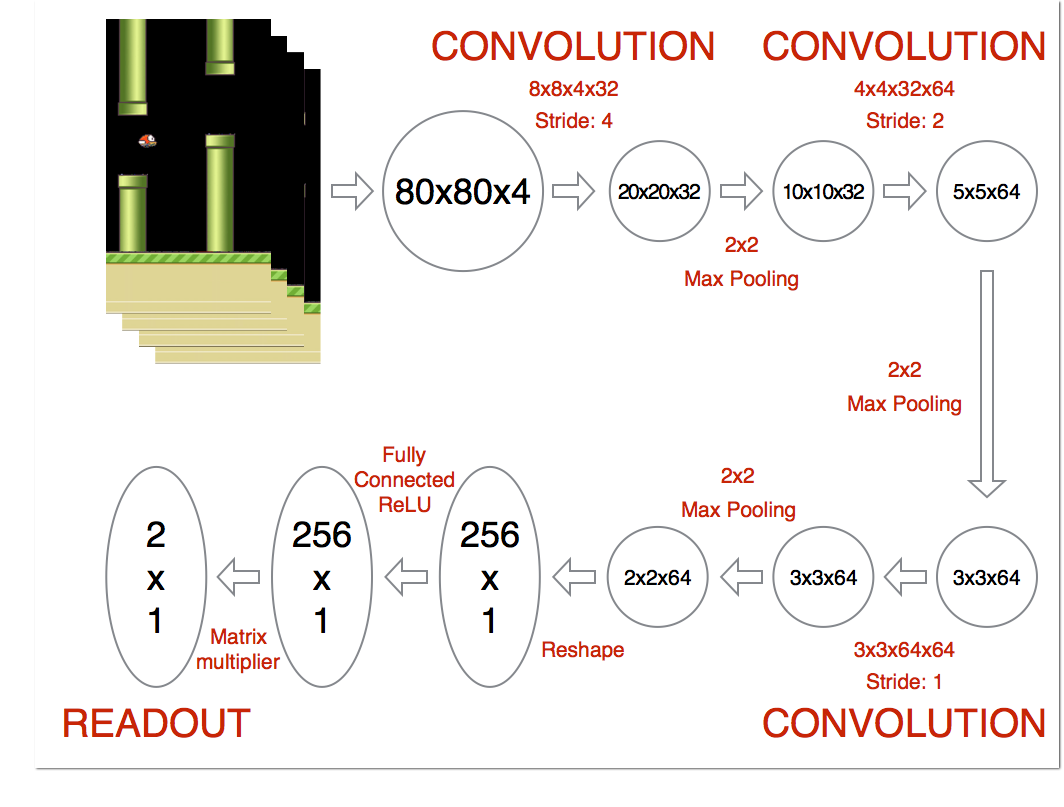

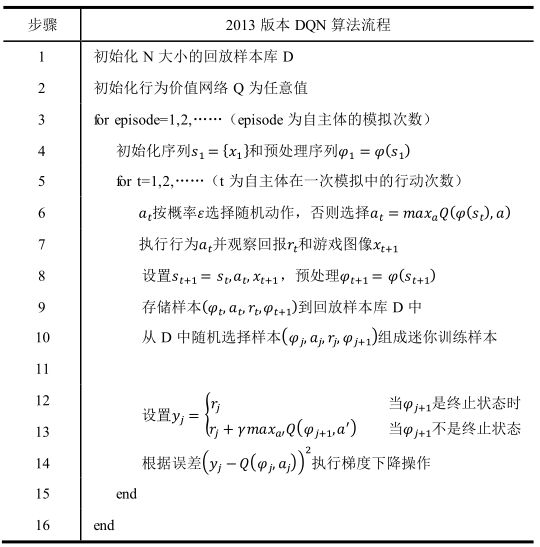

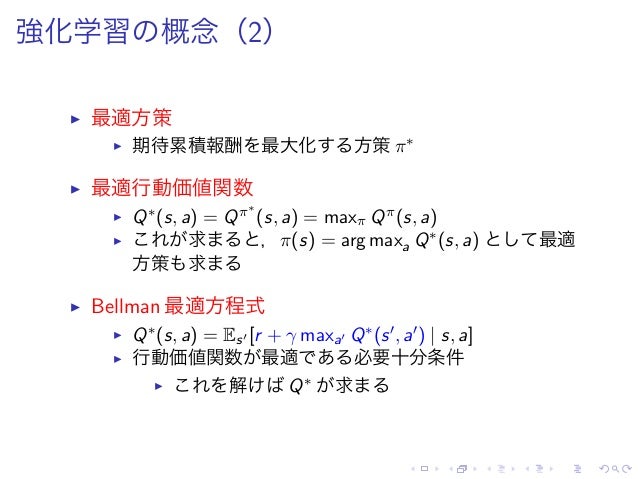

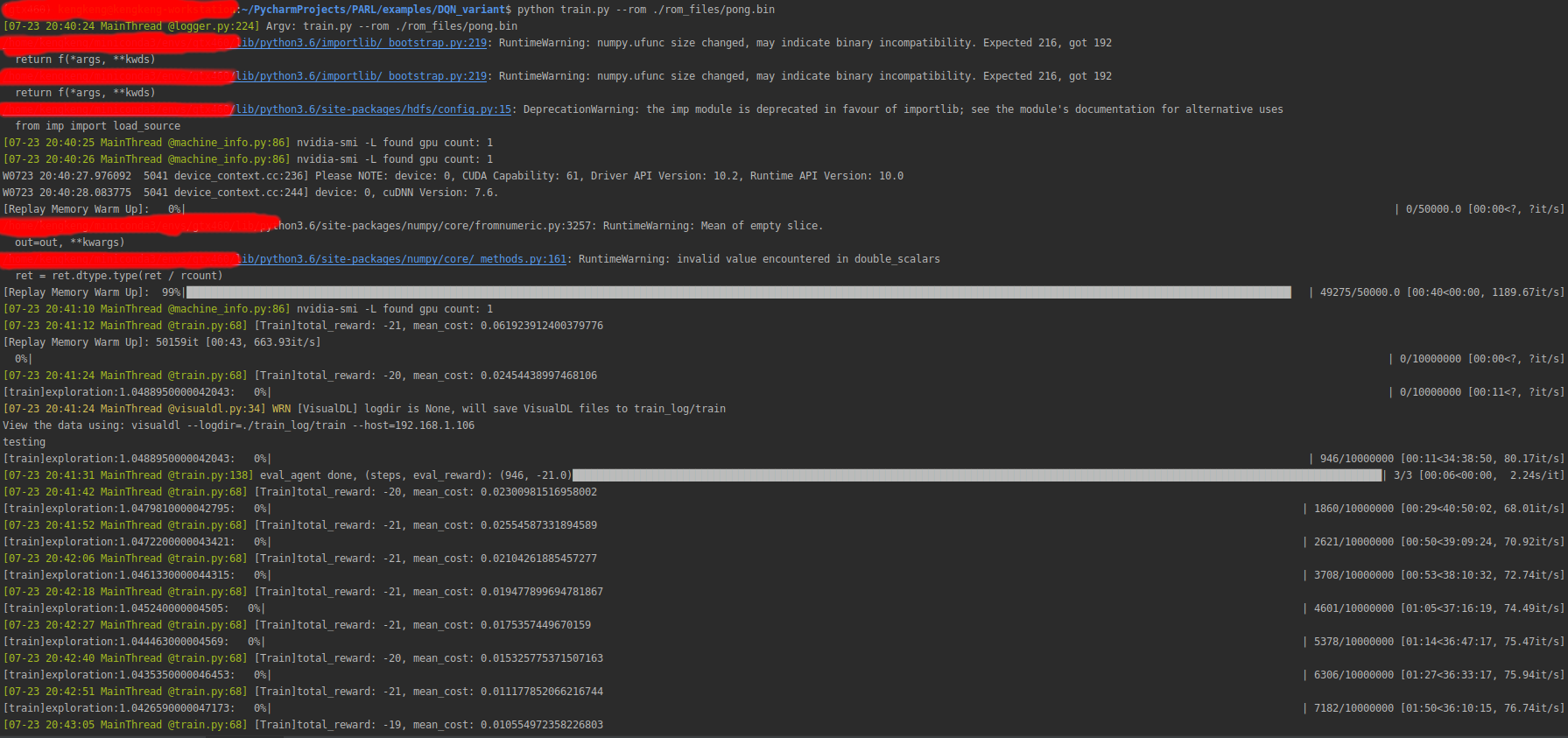

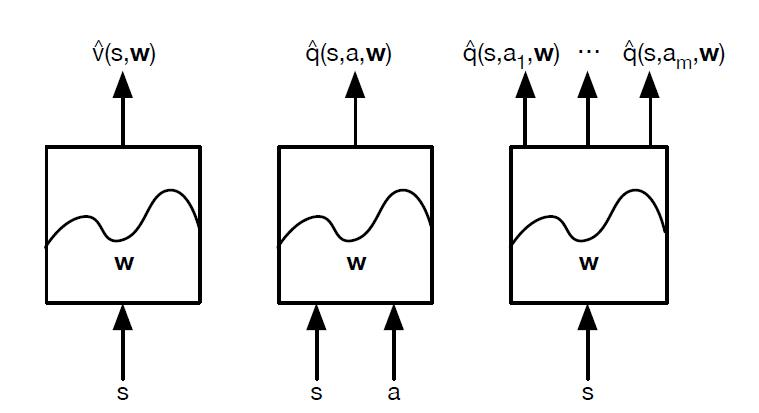

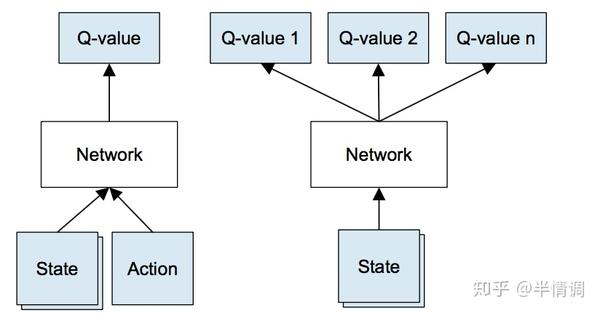

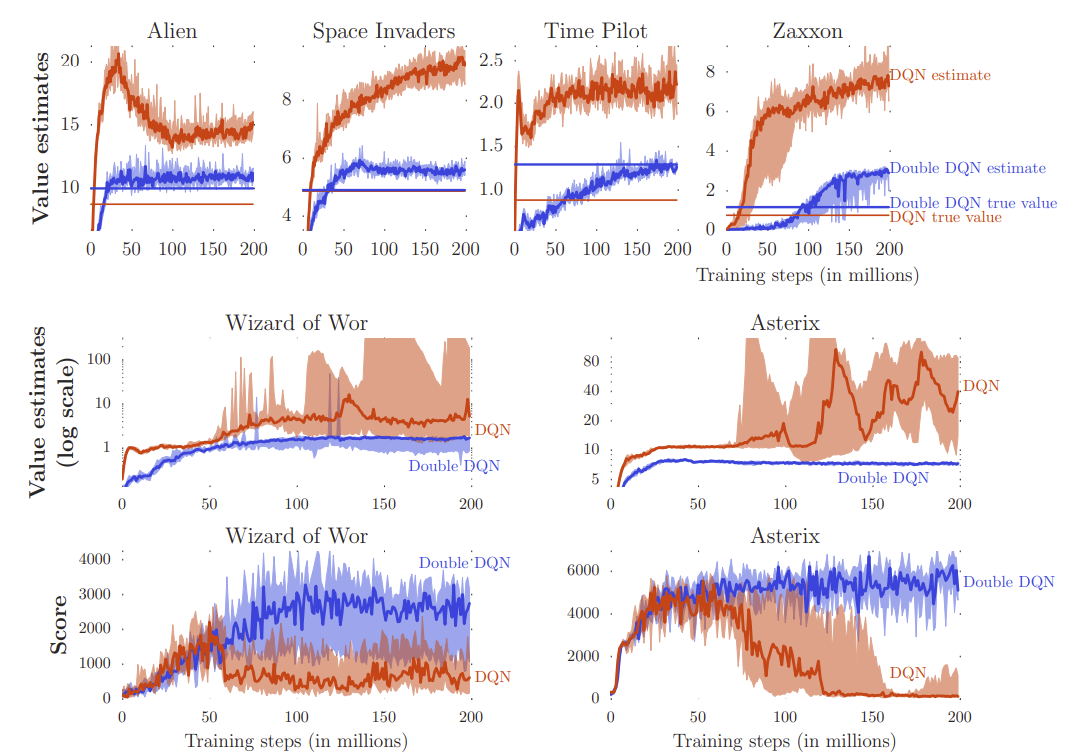

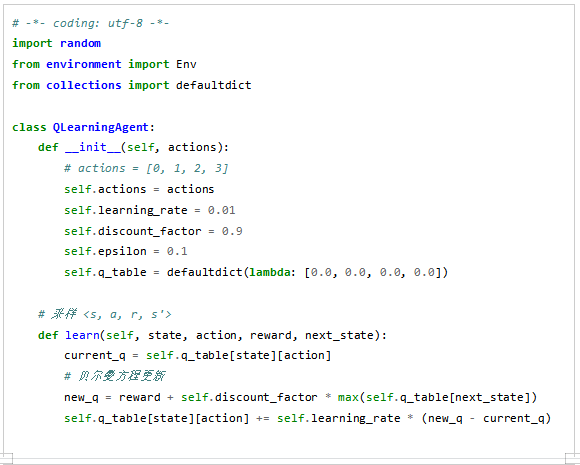

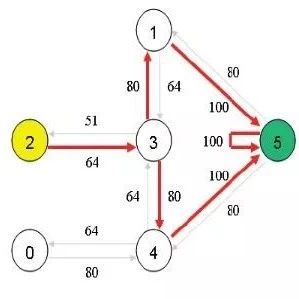

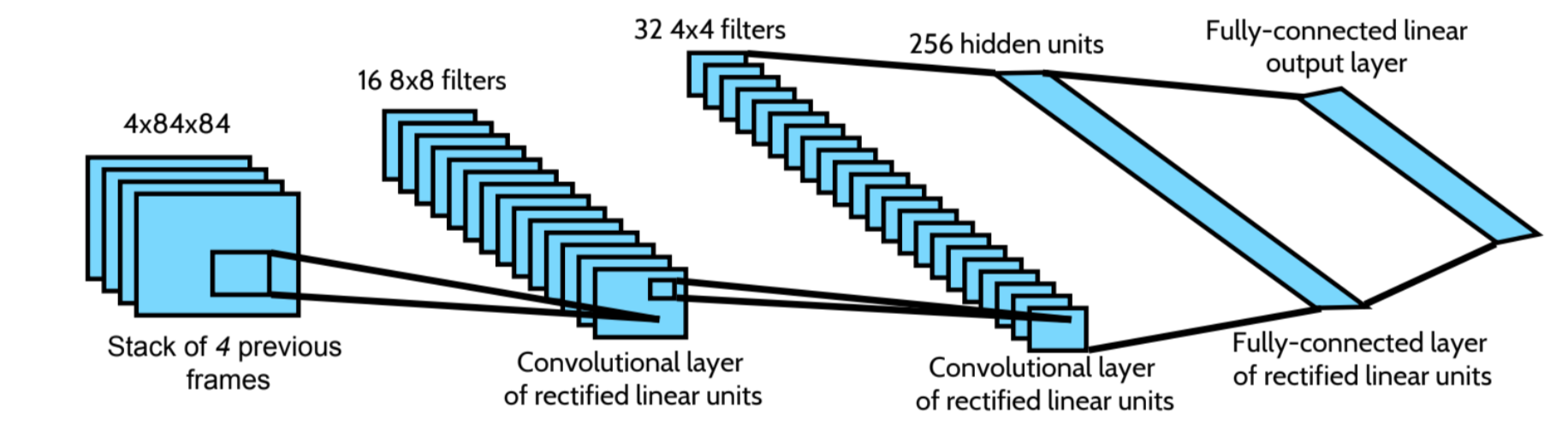

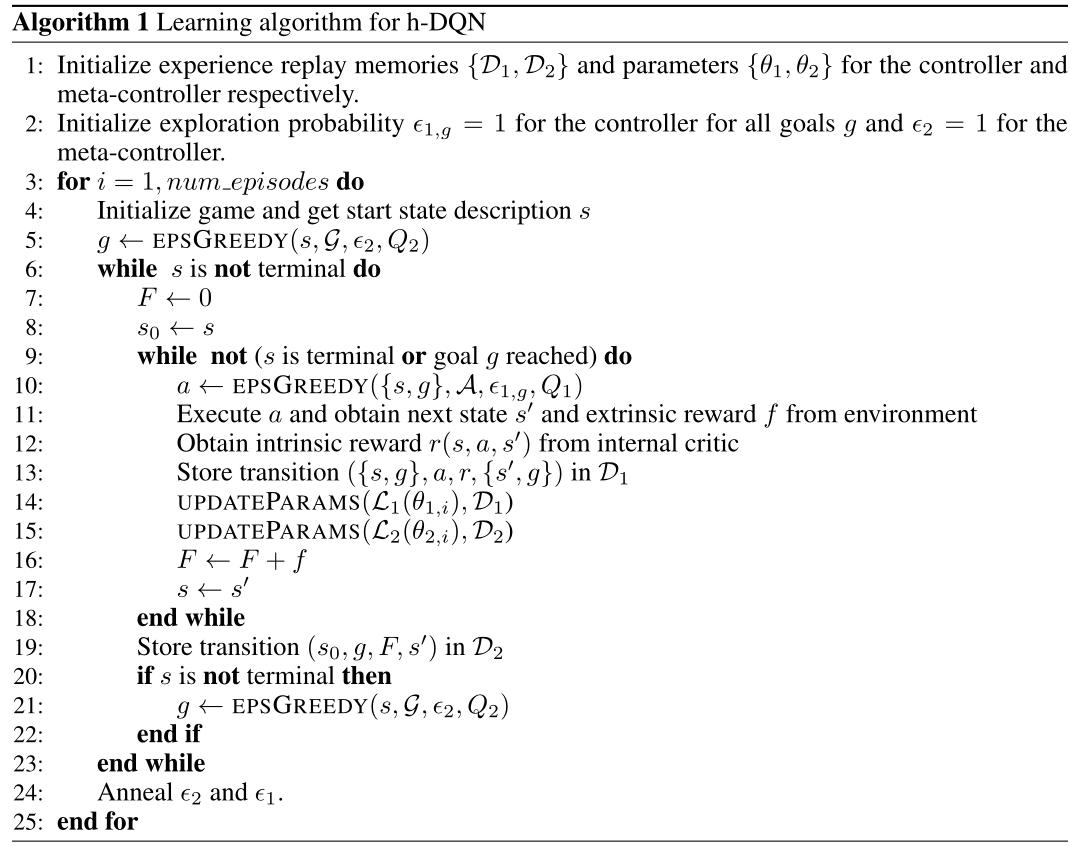

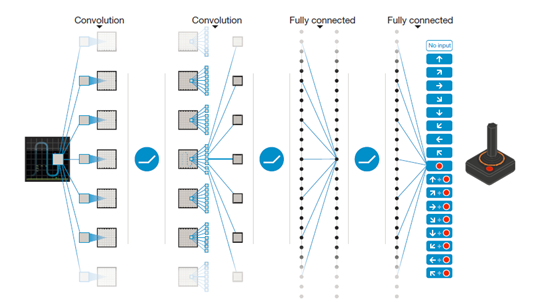

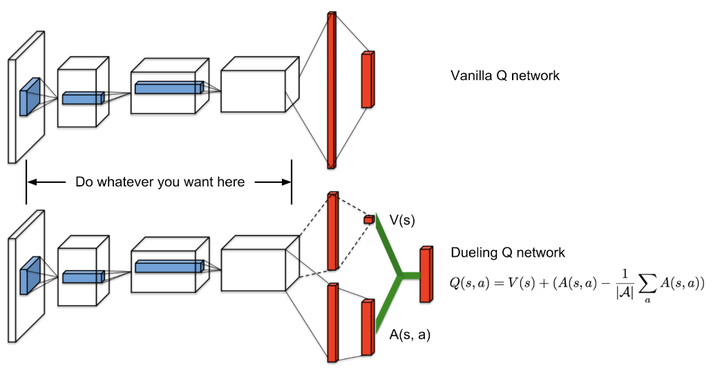

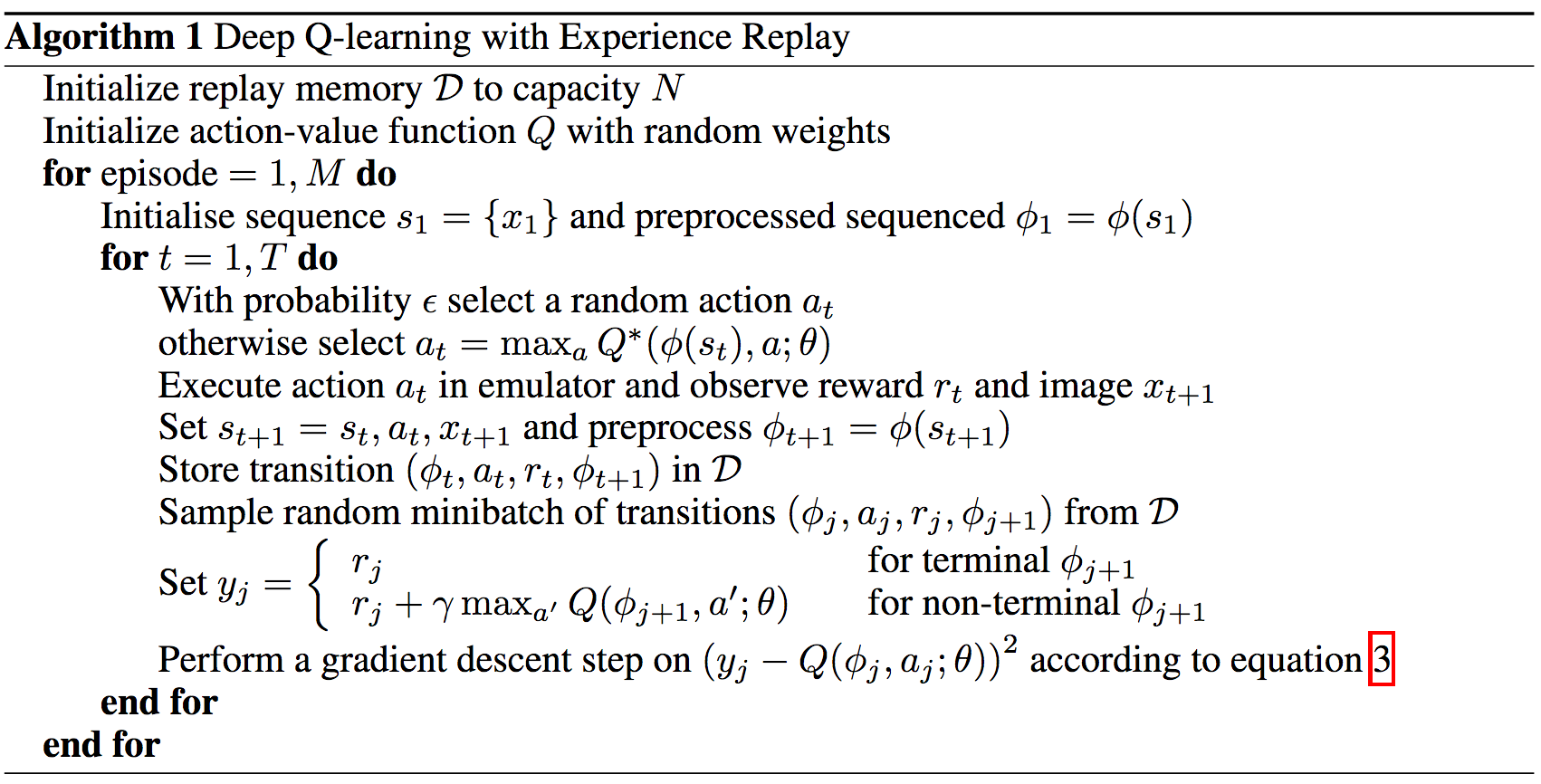

~Raibow DQNとは~ Deep Q Networkをベースとした以下の6つの改善手法全てを統合したモデル (1) Double DQN DQNの課題 Qlearningでは教師データをmaxQvalueで更新していた。 この方法だと本来は価値の高くないはずの行動を最適だと判断してQvalueの更新を行ってしまう可能性があり(過大評価)、最適な方策を DQNはQ関数をディープなニューラルネットワークにしたものでした。それには畳み込みニューラルネットワーク(CNN)を使っていて、ゲーム画面を状態\( s \)として入力し、それぞれのゲーム操作\( a \)の行動価値\( Q(s, a;\theta) \)を出力します。 BATCH_SIZE = 50 def update_dqn (replay_memory) ## メモリがバッチサイズより小さいときは何もしない if len (replay_memory) < BATCH_SIZE return ## ミニバッチ取得 transitions = replay_memorysample(BATCH_SIZE) ## (状態、行動、次の状態、報酬) バッチサイズ を (状態xバッチサイズ、行動

看alphago虐柯洁不爽 那就解剖它亲哥 集智俱乐部 财新博客 新世纪的常识传播者 财新网

Dqn 行動

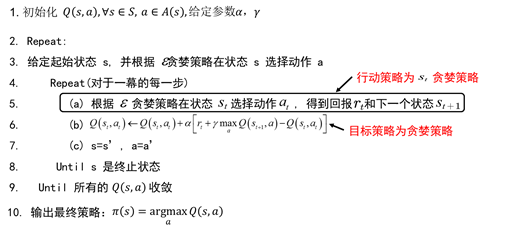

Dqn 行動-戦国DQN四天王とは、聖人が少ない戦国の世において抜きん出た所謂『dqnさ』を持つ人々を指す、ある種の称号と言えるものである。 概要 『king of dqn』とも言える4人が議論を経て、各掲示板で統一見解として決まっていた。 それをご紹介させて頂くのがこのタグの目的である。 Exploration vs Exploitation 強化学習 下 2 必要 Exploration: 知識 状態・行動 試 Exploitation: 良 状態・ 行動 試 DQN ? ϵgreedy:確率 ϵ 行動,確率 1 − ϵ Q(s, a) 最大 行動 選 最初 ϵ 1 01 , 以降 01 固定 37

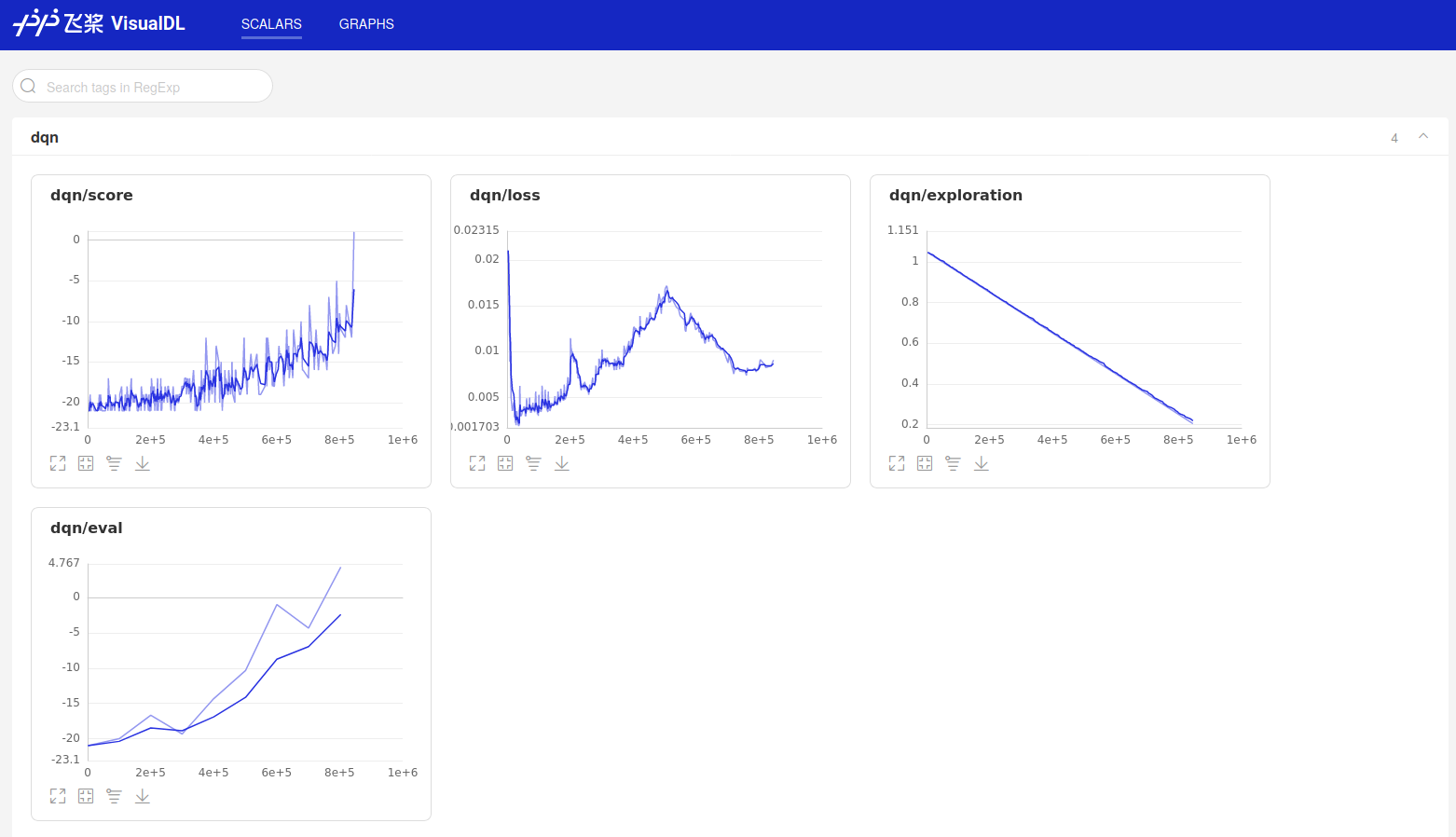

强化学习dqn及其变体原理与parl实现 飞桨ai Studio 人工智能学习实训社区

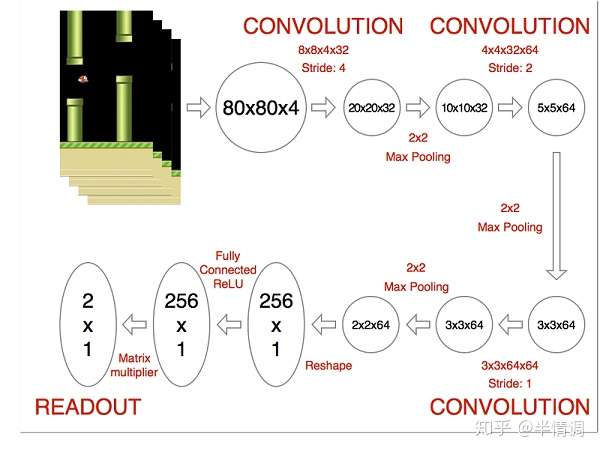

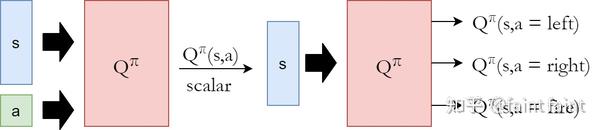

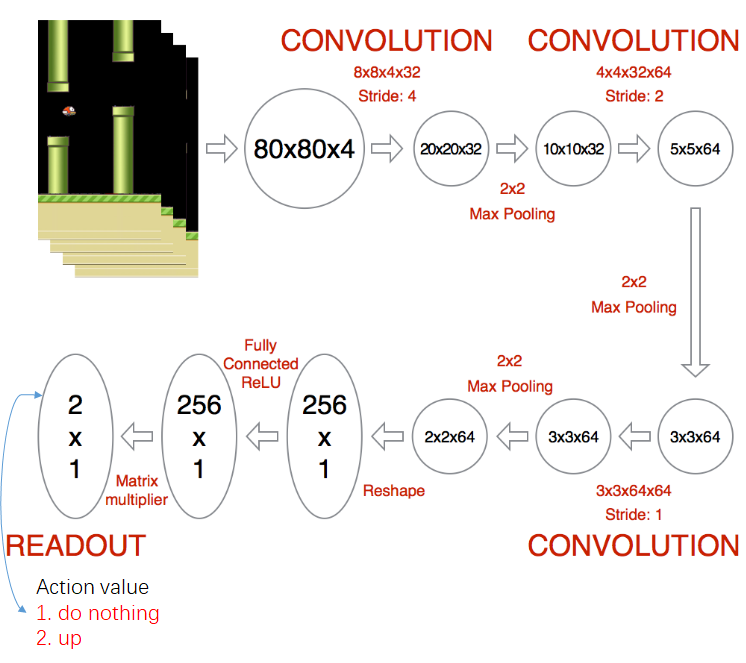

行動空間が連続的な場合は,Qlearningよりも actorcritic Sutton98Kimura98と 呼ばれる方法のほうが実績がある. これは状態のValueを評価するcriticと呼ばれる部分と,状態観測に応じて 確率的に行動選択を行うactorという2つの要素より構成される. ここでactorはDQNでは行動価値関数を畳み込みニューラルネットワーク(Convolutional Neural Network, CNN)で近似しています。CNNは入力値に画像などの行列をとり、畳み込み層のフィルターとプーリング層で入力の特徴量を処理していき、出力に画像のクラス分類予測などの確率を 荒野行動with らいむ 荒野行動Flora大会配信 荒野行動旧マップシングルゲリラが楽しい 荒野行動まさかのガチャ限定⁉3月に公認実況者コラボアイテムスキン実装決定!必要金券や入手方法パック等考察!

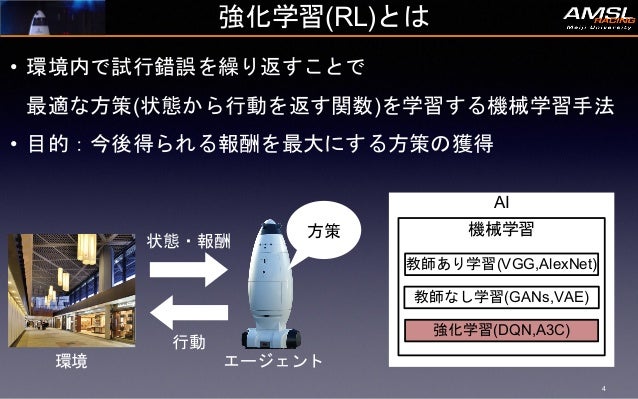

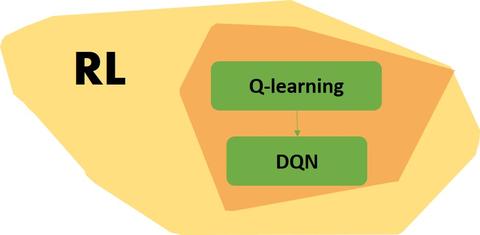

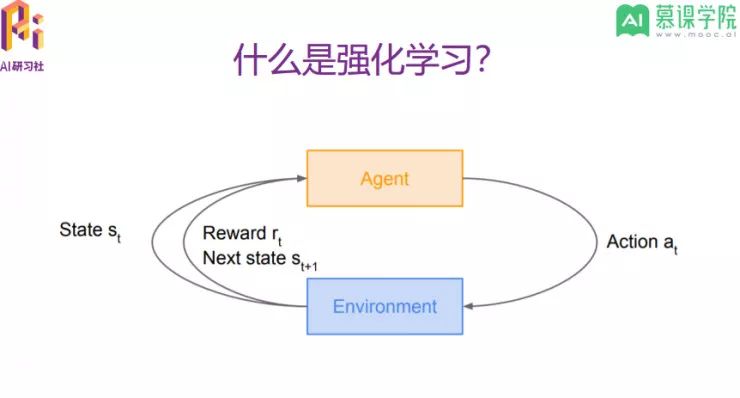

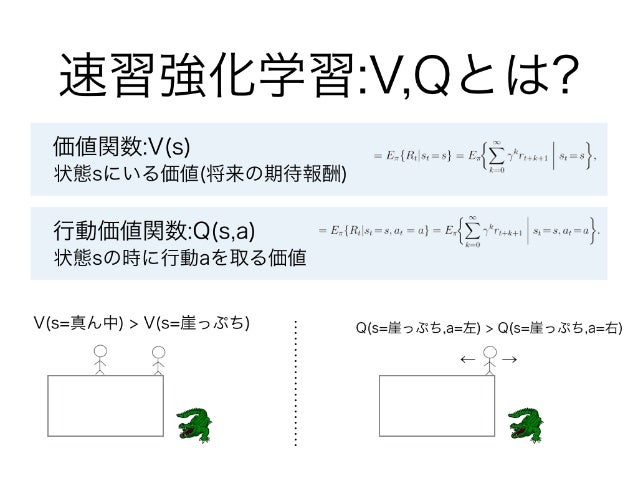

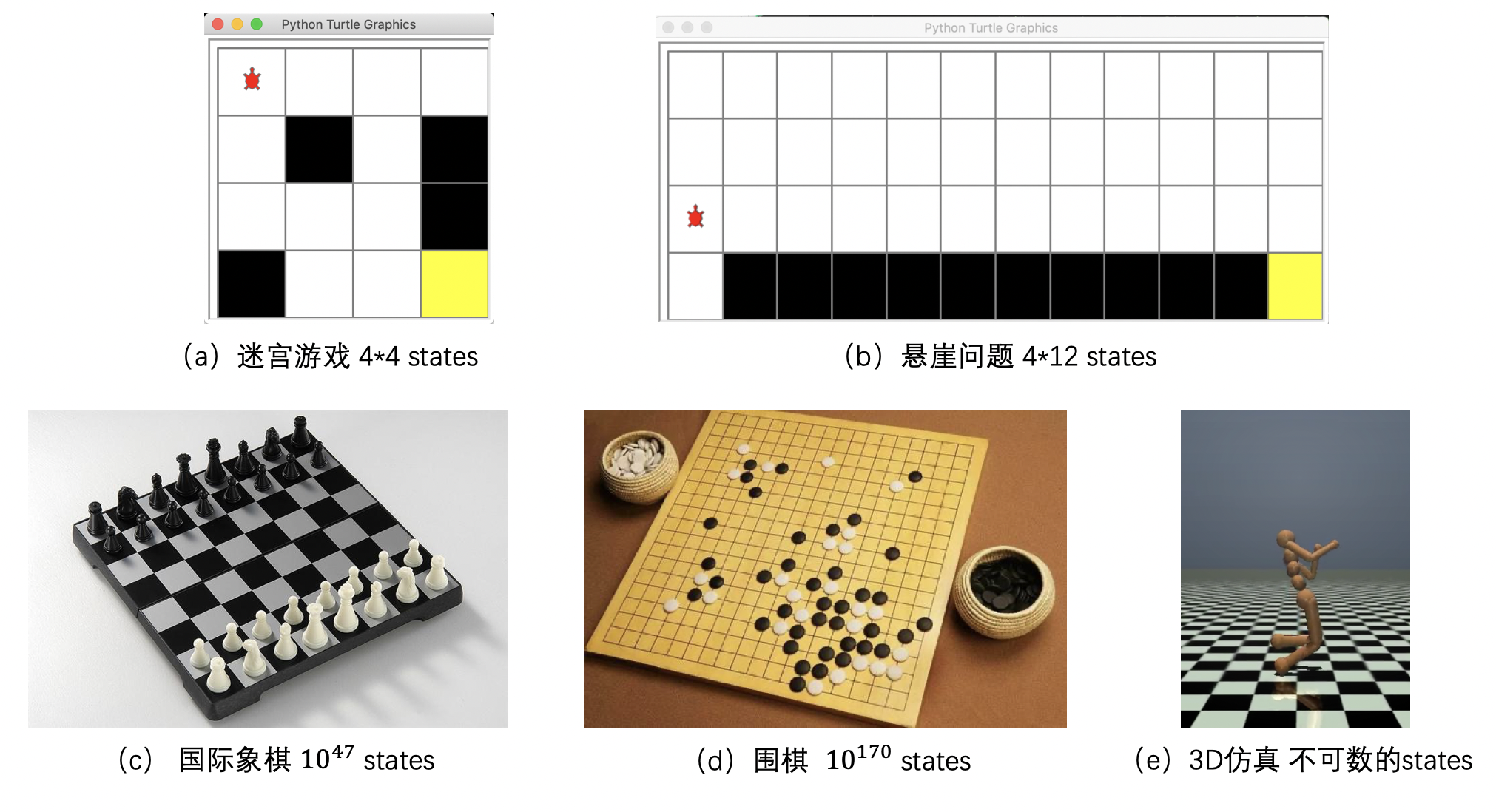

DQNとは まず、DQNを説明する前に強化学習(Reinforcement Learning)について整理しておく必要があると思います。 強化学習(きょうかがくしゅう、英 Reinforcement learning)とは、ある環境内におけるエージェントが、現在の状態を観測し、取るべき行動を決定する問題を扱う機械学習の一種。© 18 GRID INC ALL rights reserved• 状態sにおいて行動aをとった時に得られる行動価値をもとに学習 • Q関数を用いた強化学習 • QLearning, DQN, Double DQN, etc • デメリット • 行動価値の変化が行動選択に大きく影響 • Policybased • 状態sから行動aを直接決定する • デメリット

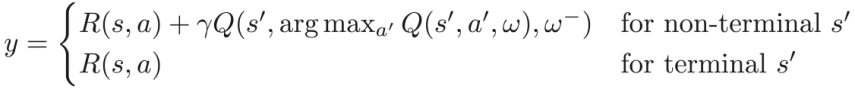

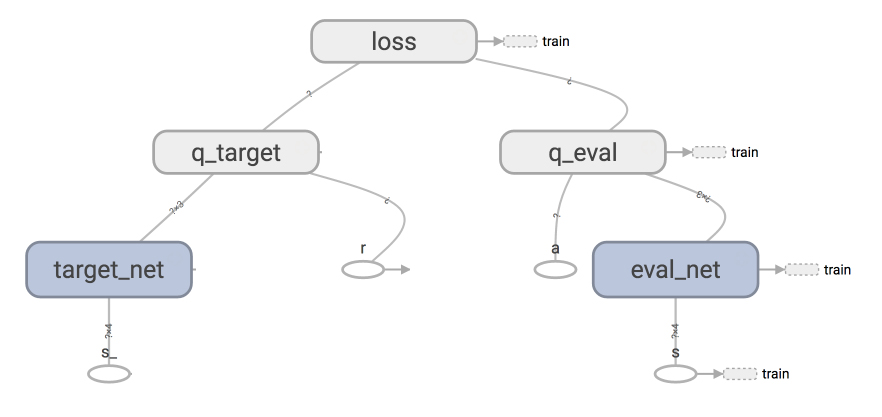

\theta_{t}\right);\theta_{t}^{}\right)\) DDQNでは mainnetwork の最大価値の行動の価値を targetnetworkで求める DDQNにより何が改善DQNでは、Huber関数を用いる。 学習の全体 ①エピソード数分のエピソードを繰り返す ②targetnetworkの更新 ③1エピソードのループ 1エピソードのループ ①εを減らす ②ランダムまたは行動価値関数にしたがって、行動の取得 ③行動に応じて状態と報酬を得る。層強化学習の代表例として DQNがある. は, Q 学習における行動価値関数を畳み込みニューラルネ ットワークに置き換えて近似したものである.DQN で は,ある状態sと行動aをニューラルネットワークに入 力すると,その状態に対応する行動選択Q(s,a)をニュ

最も共有された Dqn 行動 ベストイメージコミックスキャラクター

Rl强化学习算法90行代码快速实战dqn代码分层讲解 Ai工匠book 程序员宅基地 程序员宅基地

This script is an example of training a DQN agent against OpenAI Gym envs Both discrete and continuous action spaces are supported For continuous action spaces, A NAF (Normalized Advantage Function) is used to approximate Qvalues To solve CartPolev0, run python train_dqn_gympy env CartPolev0DQN(natureヴァージョン)のアルゴリズム 1 より よって行動を選択する ためのaction value( ) と行動を評価するため のaction value( )は微 妙に違う Q ∧ Q actionの過大評価 は若干削減された? もっと削減するには・・・ DDQN! 13 3目並べで強化学習を行うと、どうなるのだろうか。強化学習のアルゴリズムの一つである「QLearning」を説明しつつ、QLearningにDeep Learningを組み合わせた「Deep QNetwork」を使って、強化学習を実装する方法を紹介する。 (1/2)

强化学习12 什么是dqn 简书

看alphago虐柯洁不爽 那就解剖它亲哥 集智俱乐部 财新博客 新世纪的常识传播者 财新网

# DQNアルゴリズムにしたがって動作するエージェント class DQNAgent () def __init__ (self, epsilon = 099) self model = Q self optimizer = optimizers Adam self optimizer setup (self model) self epsilon = epsilon # ランダムアクションを選ぶ確率 self actions = 1, 0, 1 # 行動の選択肢 self DQNな人は、人の価値がステータスなどで決められることにウンザリしています。 勉強や運動も、思考や行動も個々に認められるべきだと考えていて、 人と比較されることが嫌 なのです。 そのため、自分を変な目でみたり馬鹿にしたりする人にはガンを The latest tweets from @DqnUaaaa

深層強化学習 自律移動ロボット

深度强化学习从入门到大师 进一步了解深度q学习 第三部分 续 译站 Ai研习社

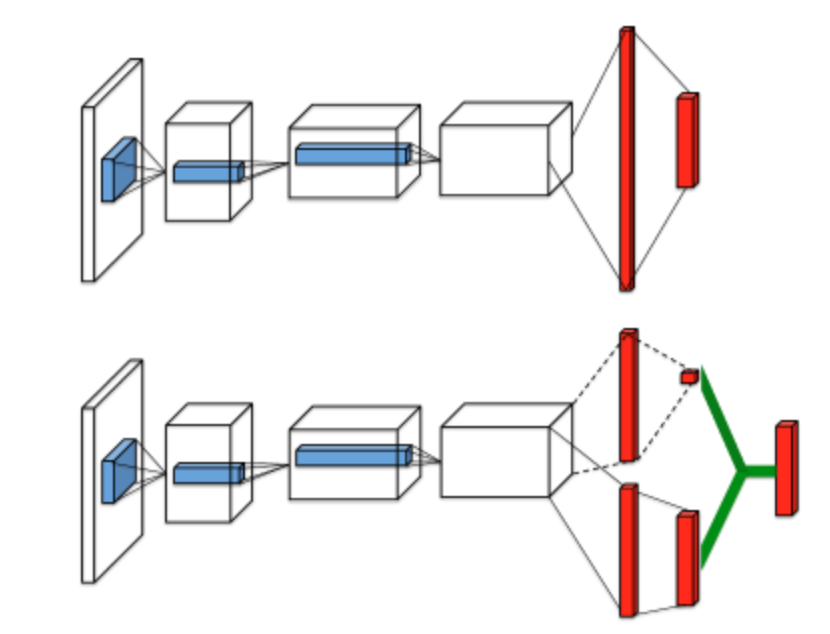

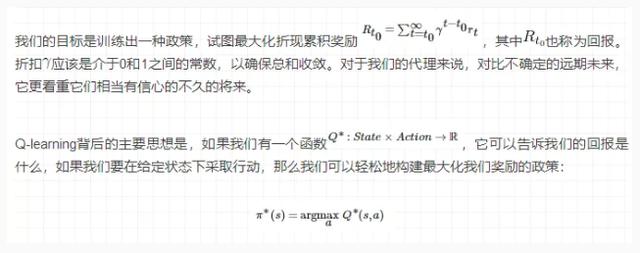

DQNでは単純に targetnetwork の最大行動価値を用いる DDQNの更新式 \(Y^{DoubleDQN}_{t} = R_{t1}\gamma{Q}\left(S_{t1}, \arg\max_{a}Q\left(S_{t1}, a; DQN親・家族の特徴3選! こんなDQN親には関わったらダメです! 人間関係 休日に街に出ると、いろいろな家族を見かけますね。 家族そろって休日を楽しむ目的は同じなのですが、時には非常識な行動で 周りを唖然とさせるDQN家族 もいて、楽しいDQNは 強化学習 に分類されます。 強化学習ではエージェント(Agent)が環境から状態(State)を受け取り、それを元に行動(Action)を起こし、 報酬(Reward)を受け取るというサイクルの中で、全体での報酬を最大化することを目的として学習します。

深度增强学习前沿算法思想 Dqn A3c Unreal 简介 Mmc15的专栏 程序员资料 程序员资料

谁说rl智能体只能在线训练 谷歌发布离线强化学习新范式 训练集相当于0多个imagenet

DeepMindでは、DQNの学習プログラムに強化学習(RL Reinforcement Learning)と呼ばれる手法を取り入れ、学習の効率をアップさせているとのこと。 RLとは

用tensorflow基于deep Q Learning Dqn 玩flappy Bird Flood Sung的专栏 Csdn博客

多agent深度强化学习综述

強化學習reinforcement Learning 人工智慧在所屬的環境 Environment 中 自己嘗試錯誤 從中找出最佳行動 By Jockey Ng Medium

强化学习dqn并玩cartpole游戏 Hibiki阿杰的博客 程序员资料 Cartpole游戏 程序员资料

强化学习 理解q Learning Dqn 全在这里 知乎

Openai发布dqn实现 提出5点做强化学习模型的最佳方法

視頻分享 斯坦福cs231n 實戰技巧 Tensorflow 實現dqn 圖像分類和網絡優化 Ai 視覺芯片 專知

篮球进化论 雷霆队是否应该少投三分球 虎扑

The Top Page Screenshot Of The Promptly Created Wiki Download Scientific Diagram

强化学习算法与应用综述

Line Tdl旅行に同行を企むdqnママ ファミリーカーあるよね 私も乗せてよ w Dqnママが自分勝手な行動し

Dqnの理論説明

李宏毅深度强化学习笔记 4 Q Learning更高阶的算法 Acl Lihan的博客 程序员宝宝 程序员宝宝

这里是强化学习入门 的入门 绝对新手友好

An Optimistic Perspective On Offline Reinforcement Learning 码农家园

强化学习 Dqn Ddayzzz

深度强化学习简介 程序员大本营

强化学习 十 Dqn的理解 知乎

李宏毅深度强化学习笔记 4 Q Learning更高阶的算法 Acl Lihan的博客 程序员宝宝 程序员宝宝

Deep Q Network 論文輪読会

强化学习之基于gym环境的dqn算法实战 Pytorch Ton的博客 Csdn博客

最近のdqn

强化学习 Dqn Ddayzzz

强化学习dqn及其变体原理与parl实现 飞桨ai Studio 人工智能学习实训社区

强化学习 3 Dqn

强化学习 Dqn Ddayzzz

计算机科学 一种解决神经控制问题的深层强化学习方法 每日头条

深度强化学习 深度q网络 Dqn 介绍 网易订阅

老陈的强化学习 Reinforcement Learning 笔记5 Q Learning Dqn 知乎

十三 最新进展和后续步骤 Python 强化学习实用指南 生产力导航 Awesome

资源 Openai Five 战胜的秘诀

Reinforcement Learning 基于价值的强化学习

揭秘深度强化学习 7dqn的一些小技巧 Qq 的博客 Csdn博客

读书笔记 深入浅出强化学习 思维导图 Reinforce Learning 及前两章节选

强化学习 Dqn系列 Dqn Nature Dqn Ddqn Dueling Dqn等 程序员宅基地

强化学习 十 Dqn的理解 知乎

强化学习dqn及其变体原理与parl实现 飞桨ai Studio 人工智能学习实训社区

Dqn Paddleedu Documentation

Amazon Com 读懂真正的美国 绝密行动 美国中情局行动大揭密 哈佛美国史 套装共2册 美 钱宁徐枫 Libros

经典的强化学习算法 Dqn 动作

深度强化学习 深度q网络 Dqn 介绍 雷锋网

視頻分享 斯坦福cs231n 實戰技巧 Tensorflow 實現dqn 圖像分類和網絡優化 Ai 視覺芯片 專知

看alphago虐柯洁不爽 那就解剖它亲哥 集智俱乐部 财新博客 新世纪的常识传播者 财新网

Dqn 的算法思想和代码实现 简书

篇強化學習論文總結 幫趣

强化学习 Reinforcement Learning 中的q Learning Dqn 面试看这篇就够了

機器不學習 強化學習 四 從dqn到ddpg 每日頭條

揭秘人工智能缘何屡次战胜人 已接近人类大脑 中国新闻网

Pytorch 强化学习01 强化学习 Dqn 睡前人工智能共享实验室 程序员宝宝 程序员宝宝

奇安信攻防社区 记一次自动化渗透测试的学习研究

深度强化学习 Dqn Deep Q Network 之应用 Flappy Bird W X W1985 博客园

深度强化学习 深度q网络 Dqn 介绍 网易订阅

Deep Mind的noisynet建议随机性好 程序员部落

强化学习扫盲贴 从q Learning到dqn 专知

Reinforcement Learning 基于价值的强化学习

Cedec 19 Speakers Interview Series The 3rd Installment Our Talents Go Beyond Creating The Powerful Creating Enemy Ai For A 3d Action Game Using Deep Learning Luminous Productions

强化学习dqn及其变体原理与parl实现 飞桨ai Studio 人工智能学习实训社区

Deep Q Learning 系列论文漫谈 一 从q Learning到dqn Our Home

强化学习12 什么是dqn 简书

深度强化学习的攻防与安全性分析综述

Dqnの理論説明

Dqnなりたい 40代で死にたい Song By Kyuso Nekokami Spotify

Dqn 的算法思想和代码实现 简书

Deep Q Learning 系列论文漫谈 一 从q Learning到dqn Our Home

深度增强学习 Dqn 的各种改进 王江源 新浪博客

十三 最新进展和后续步骤 Python 强化学习实用指南 生产力导航 Awesome

深度强化学习从入门到大师 进一步了解深度q学习 第三部分 续 译站 Ai研习社

Amazon Com 读懂真正的美国 绝密行动 美国中情局行动大揭密 哈佛美国史 套装共2册 美 钱宁徐枫 Libros

强化学习 算法deep Q Learning Vortex

强化学习 Reinforcement Learning 中的q Learning Dqn 面试看这篇就够了

强化学习 Reinforcement Learning 中的q Learning Dqn 面试看这篇就够了

强化学习如何使用内在动机 湃客 澎湃新闻 The Paper

深度强化学习 深度q网络 Dqn 介绍 雷锋网

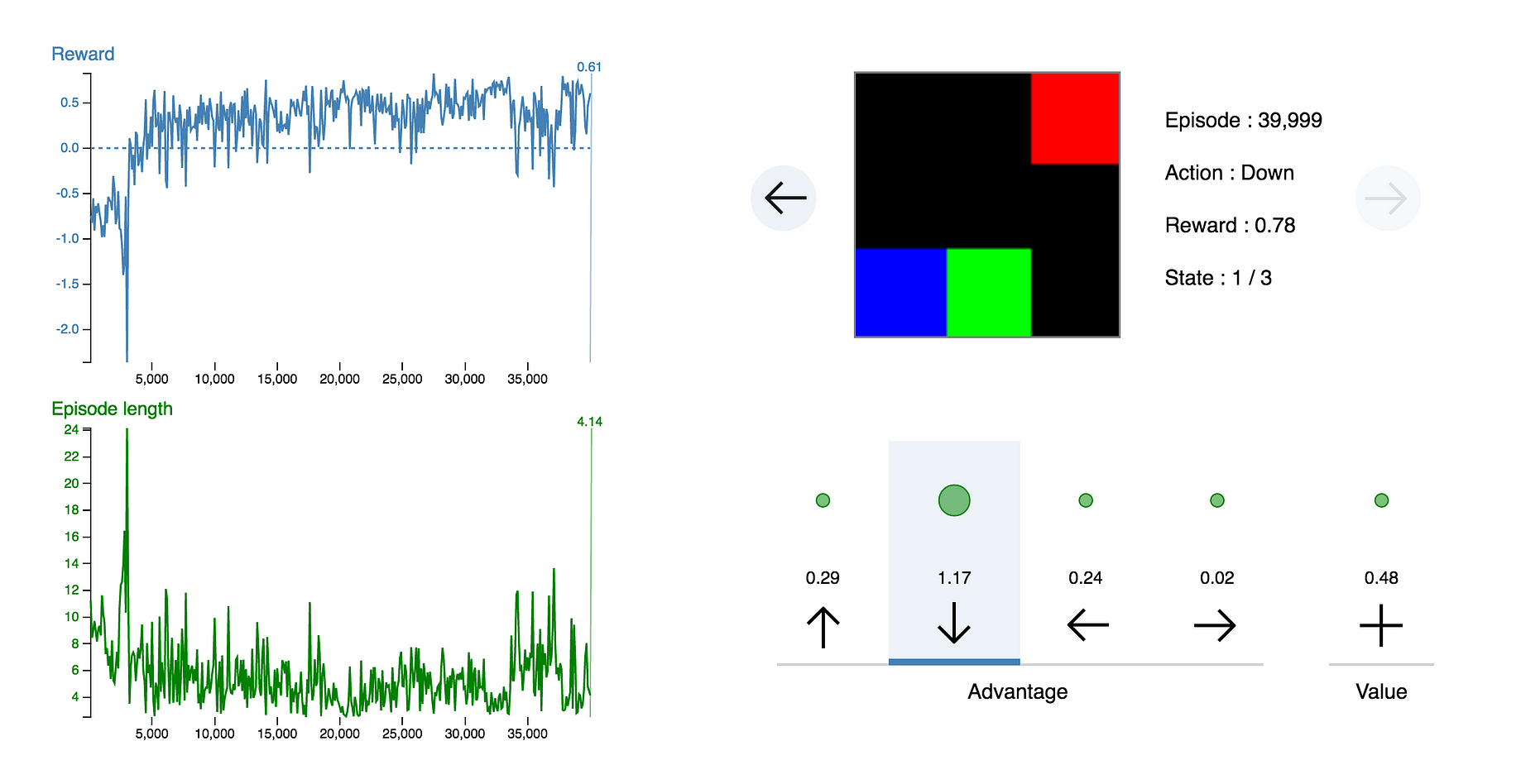

Simple Reinforcement Learning With Tensorflow Part 5 Visualizing An Agent S Thoughts And Actions By Arthur Juliani Medium

强化学习dqn及其变体原理与parl实现 飞桨ai Studio 人工智能学习实训社区

Deep Reinforcement Learning For Online Advertising In Recommender Systems 阅读笔记 随风而行的个人博客

深度强化学习从入门到大师 进一步了解深度q学习 第三部分 续 译站 Ai研习社

强化学习 十 Dqn的理解 知乎

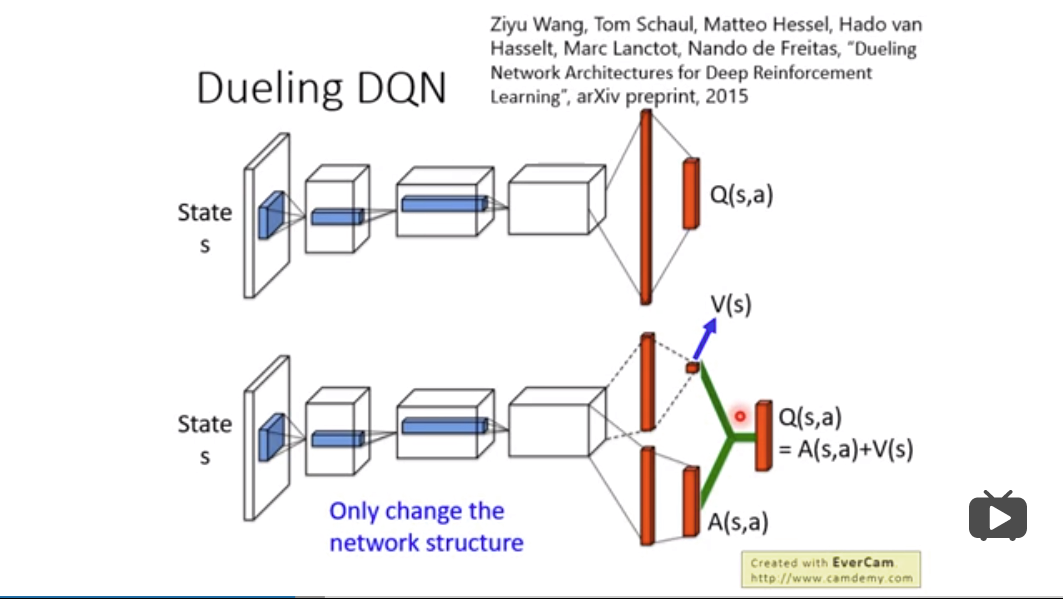

Pytorch深度强化学习3 Ddqn和dueling Dqn 知乎

Paddlepaddle版flappy Bird 使用dqn算法实现游戏智能 机器之心

谁说rl智能体只能在线训练 谷歌发布离线强化学习新范式 训练集相当于0多个imagenet

Reinforcement Learning 基于价值的强化学习

强化学习dqn实践 Cartpole V0完整代码分析 详细注释 Ytianye的博客 程序员宝宝 程序员宝宝

深度强化学习 深度q网络 Dqn 介绍 雷锋网

深度强化学习理论及其应用综述

谁说rl智能体只能在线训练 谷歌发布离线强化学习新范式 训练集相当于0多个imagenet

深度强化学习系列第一讲dqn 知乎

第一期 篇强化学习论文总结 附下载链接 机器之心 Mdeditor

Ai学习笔记 深度q Learning Deep Q Learing Dqn Steemit

Torch Dqn算法 Ai者 高效 技术革命者也 禅者 觉悟 超脱者也 程序员宅基地 Torch算法 程序员宅基地

Deep Q Learning 系列论文漫谈 一 从q Learning到dqn Our Home

如何让多个智能体学会一起完成同一个任务 学会彼此合作和相互竞争 电子发烧友网

0 件のコメント:

コメントを投稿